Zjawisko spadków danych rankingowych i statystycznych jest jedną z najbardziej niepożądanych sytuacji w e-marketingu. W tym artykule opiszemy najczęściej występujące rodzaje spadków dotyczące witryn internetowych. Odpowiemy także, między innymi, na pytania:

- Dlaczego Twoja strona spadła w wynikach wyszukiwania wybranych fraz w Google?

- Dlaczego spadł ruch organiczny na Twojej stronie?

- Dlaczego spadła ogólna widoczność Twojej witryny w wynikach wyszukiwania?

Spadki w Google – ogólna charakterystyka

Pogorszenie się kondycji witryny jest przez jej właściciela najczęściej identyfikowane z przynajmniej jednym z poniższych zjawisk:

- Spadek pozycji witryny na systematycznie monitorowane frazy.

Codzienny monitoring określonej listy fraz warto rozszerzyć o podsumowanie miesięczne w formie wyliczenia średnich arytmetycznych z pozycji fraz w poszczególnych dniach (np. z dokładnością do jednego miejsca po przecinku). Dzięki temu unikniemy wybiórczych danych, w przypadku których łatwo jest o przekłamania. Zestawienie średnich arytmetycznych z poszczególnych miesięcy pozwoli nam dokładniej ocenić aktualną tendencję zmian pozycji.

- Spadek ruchu organicznego i – co jest z tym najczęściej związane – spadek konwersji.

Gorsze wskaźniki w Google Analytics czasem mogą nie świadczyć o realnym spadku ruchu. Problemem może być np. błąd w kodzie śledzenia. Tymczasowo niższy poziom ruchu, związany z sezonowością witryny, także nie powinien być powodem do nadmiernych zmartwień.

- Spadek widoczności w wynikach wyszukiwania.

Warto systematycznie kontrolować i analizować poziom widoczności domeny w bezpłatnych wynikach wyszukiwania. Można to zrobić w narzędziu Google Search Console, sprawdzając statystyki kliknięć i wyświetleń. Lepszy pogląd na zmianę liczby słów zarówno w TOP, jak i globalnie, da nam narzędzie zewnętrzne – np. Senuto. Dane tego typu pozwalają nie tylko rozpoznać ewentualny problem z witryną, ale i wykorzystać potencjalne możliwości poprawy widoczności dzięki np. przemyślanemu rozwojowi treści na stronie.

Spadki w statystykach domeny w Google a monitorowanie jej kondycji

Monitorując kondycję domeny, warto zwracać uwagę między innymi na wskaźniki witryny związane z jej widocznością w wynikach wyszukiwania:

- Poziom ruchu organicznego w Google Analytics – najlepiej zerkać też na liczbę wyświetleń i kliknięć w Google Search Console oraz wszystkie inne wskaźniki i raporty dostępne w GSC.

- Widoczność witryny na frazy w narzędziu zewnętrznym (np. Senuto, Semstorm) lub w Google Search Console.

- Profil linków witryny – badamy go za pomocą narzędzia, np. Ahrefs.com lub Majestic.com.

- Liczbę zaindeksowanych podstron – poziom rozbudowania witryny.

- Przyczyny spadków widoczności, ruchu użytkowników oraz pozycji fraz są ze sobą w zdecydowanej większości przypadków ściśle powiązane. Omówimy te przyczyny, nie kategoryzując ich jednak pod kątem negatywnych zjawisk (spadku ruchu, widoczności czy pozycji fraz), którymi skutkują.

W dalszej części artykułu opisane zostaną poszczególne przyczyny występowania spadków.

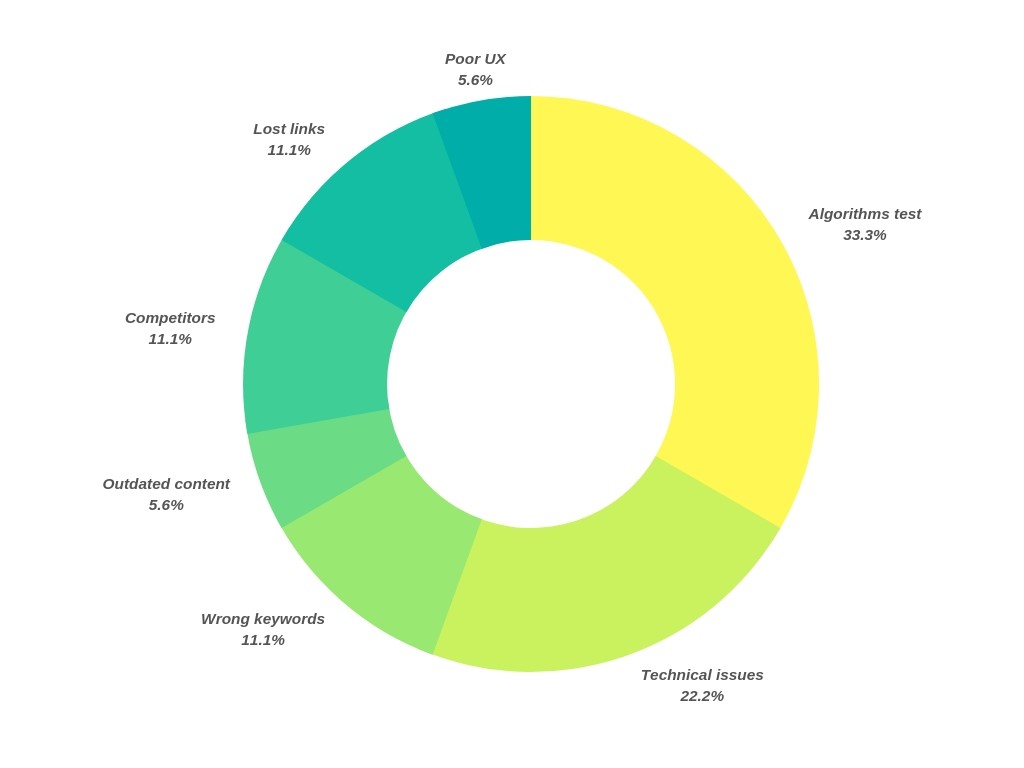

Udział procentowy w występowaniu poszczególnych powodów spadków w wynikach wyszukiwania, na podstawie osobistych obserwacji jednego z autorów portalu searchenginewatch.com

Problemy z kodem śledzenia

Po odnotowaniu spadku ruchu organicznego w Google Analytics warto w pierwszej kolejności porównać jego poziom z liczbą kliknięć w Google Search Console. Są to, co prawda, zupełnie inne wskaźniki ale ich poziom powinien być zbliżony względem siebie.

Wystąpienie dużych rozbieżności świadczyć będzie o tym, że np. kod śledzenia jest niepoprawnie wdrożony (błąd mógł pojawić się np. przy okazji wprowadzania innych zmian na stronie; inny przykład: podwójna publikacja kodu śledzenia) lub ruch pochodzący z Google Ads jest błędnie kwalifikowany do ruchu organicznego.

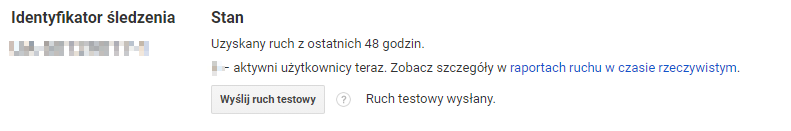

Wstępną informację, dotyczącą poprawności kodu śledzenia, znajdziemy w panelu Google Analytics, w zakładce: Administracja → Informacje o śledzeniu → Kod śledzenia.

Stan kodu śledzenia wyświetlany w ustawieniach Google Analytics

Można też zerknąć na liczbę aktywnych użytkowników znajdujących się w danym momencie na stronie (w zakładce Czas rzeczywisty → Przegląd).

Raport wyświetlający liczbę aktywnych użytkowników na żywo

W przypadku wątpliwości dotyczących prawidłowego działania kodu śledzenia, warto zapoznać się z dokumentacją: https://support.google.com/analytics/answer/1008083?hl=pl lub skontaktować się z programistą.

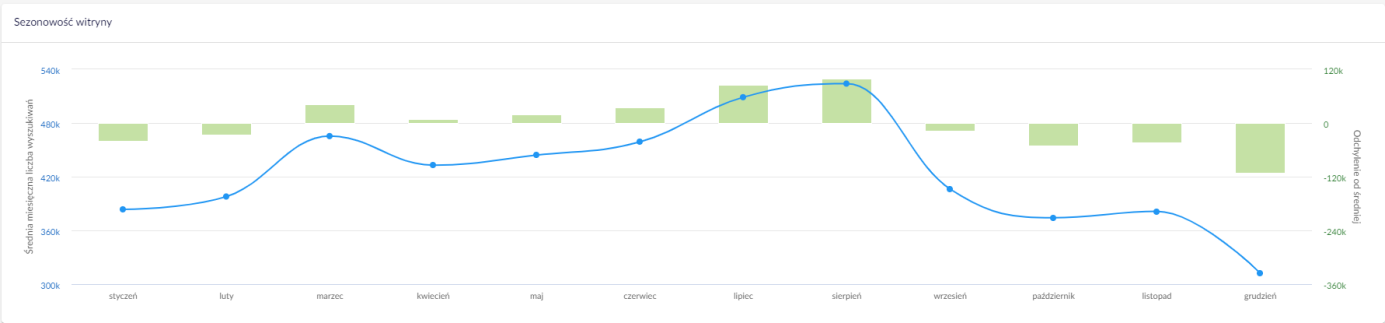

Sezonowość witryny

Mniejszy poziom ruchu organicznego w danym miesiącu może być po prostu wynikiem sezonowości witryny. Sprzedając np. parasolki, będziemy mieć większy potencjał ruchu organicznego oczywiście jesienią. Dane dotyczące sezonowości znajdziemy:

1. W narzędziu Senuto, na głównym ekranie analizy domeny:

Przykładowy wykres sezonowości witryny w narzędziu Senuto

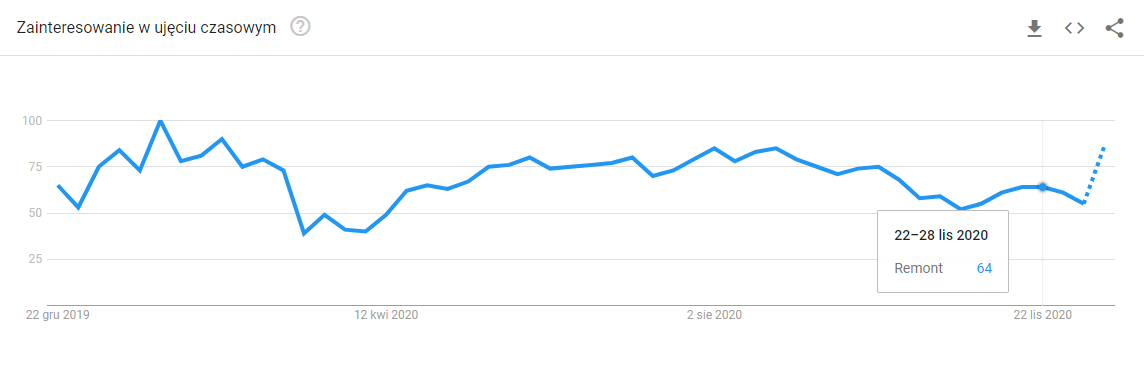

2. W narzędziu Google Trends sprawdzimy trendy wyszukiwania dla danej tematyki/fraz kluczowych:

Zainteresowanie tematem remontu w ujęciu czasowych; źródło: Google Trends

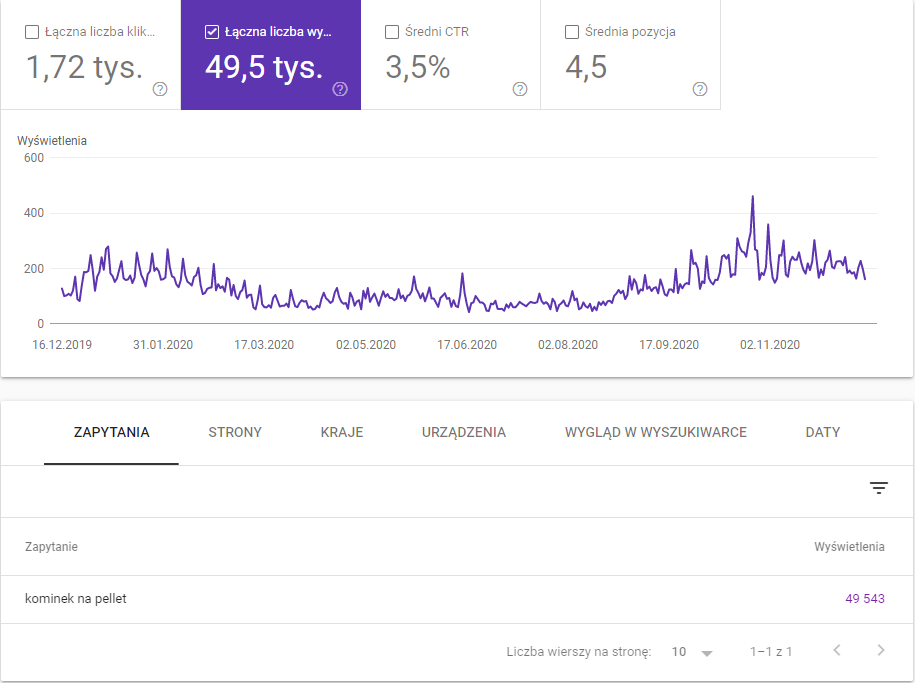

3. W narzędziu Google Search Console, jako liczbę wyświetleń na dane frazy. Na zmianę poziomu tego wskaźnika ma też wpływ właśnie sezonowość danej tematyki:

Zmiana liczby wyświetleń witryny w skali roku, na konkretną frazę; źródło: Google Search Console

Oczywiście nie mamy większego wpływu na zjawisko sezonowości, działania SEO z założenia powinny trwać nieprzerwanie przez cały rok. Dobry marketingowiec powinien jednak tak zintensyfikować swoje działania, aby w okresie największego popytu maksymalizować zasięgi, wspierając się także m.in. w większym stopniu ruchem płatnym.

Aktualizacje i testowanie zmian w algorytmie Google

Pomniejsze zmiany w algorytmie wyszukiwarki są wdrażane nieustannie, bez informowania opinii publicznej. Istotne aktualizacje, w znaczny sposób przekładające się na kondycję wielu witryn internetowych są od 2012 r. wdrażane przynajmniej raz na 12 miesięcy. Właściciel najpopularniejszej wyszukiwarki ma także w zwyczaju „testować” nowe rozwiązania, tymczasowo zmieniając ranking wyszukiwarki lub znacznie spowalniając indeksowanie witryn.

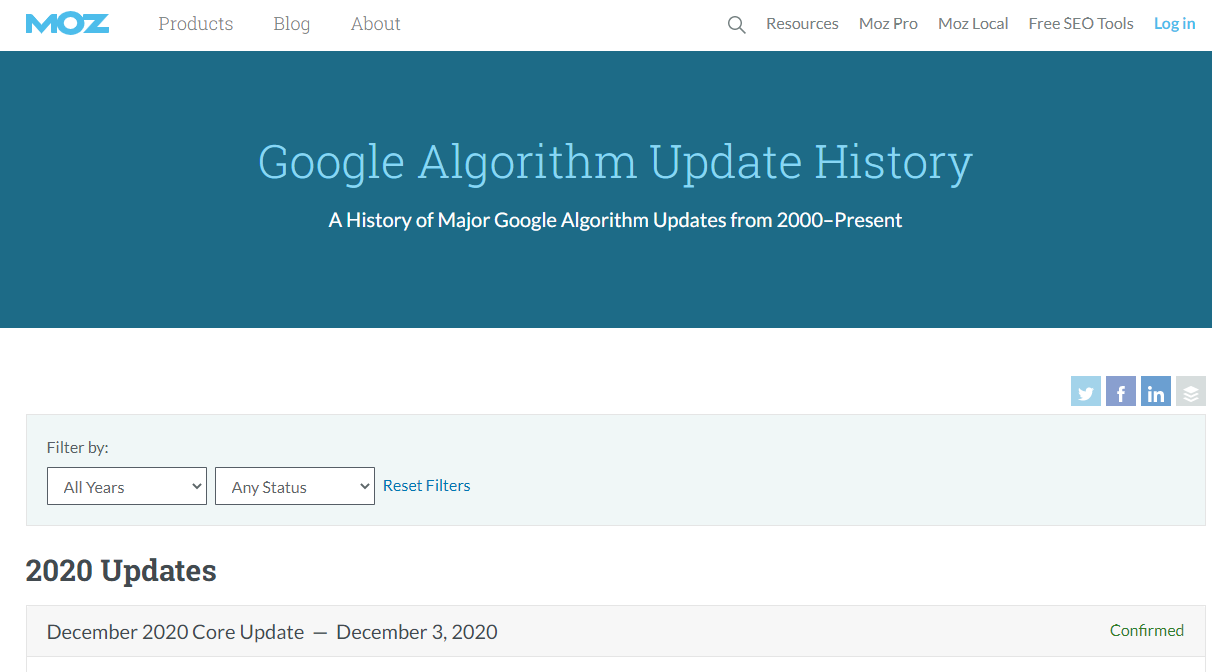

W przypadku wystąpienia spadku ruchu lub widoczności warto więc także sprawdzić na blogach branżowych najnowsze informacje o zmianach czy testach, prowadzonych przez giganta z Mountain View.

Historia zmian aktualizacji algorytmu zaprezentowana jest na https://moz.com/google-algorithm-change

Utrata linków zewnętrznych

Jeśli nasza domena w krótkim czasie utraci znaczną ilość zewnętrznych linków przychodzących, może wystąpić spadek widoczności i, co za tym idzie, ruchu organicznego. Może być to szczególnie zauważalne w przypadku utraty odnośników typu site-wide lub opublikowanych na „mocnych” domenach.

Wykres zmiany liczby linków/domen linkujących sprawdzimy w narzędziu Ahrefs (głównie wykresy „Referring domains” oraz „New & lost referring domains”).

Problemy związane z publikacją nowej wersji strony www lub zmianą domeny

Publikacja nowej wersji serwisu internetowego jest jednym z najczęstszych przyczyn wystąpienia spadków widoczności oraz spadków ruchu organicznego.

Decydując się na taki krok, powinno się wykonać szereg czynności zabezpieczających domenę przed niebezpieczeństwem wystąpienia spadków, chodzi m.in. o przekierowania adresów URL, zadbanie o jakość treści oraz wykonanie pełnego audytu SEO i UX nowej wersji witryny.

Osobliwym zjawiskiem bywają koncepcje wdrożenia w szerokim zakresie technologii Ajax (ładując całość lub część treści m.in. tekstowych w sposób dynamiczny – po załadowaniu się głównego wątku podstrony). Treść taka jest indeksowalna ale – jak wynika z doświadczenia specjalistów SEO – posiada zdecydowanie niższy potencjał rankowania w wyszukiwarce.

Twórcy stron www mają w zwyczaju blokować je dla robotów wyszukiwarki na czas ich tworzenia. Jest to uzasadnione i poprawne działanie, mające na celu uniknięcie szkodliwego zjawiska duplikacji treści. Nierzadko jednak zdarzają się sytuacje, w których blokada taka nie jest zdejmowana w momencie publikacji serwisu. Oczywiście skutkuje to wyindeksowaniem strony z Google i bardzo gwałtownymi spadkami.

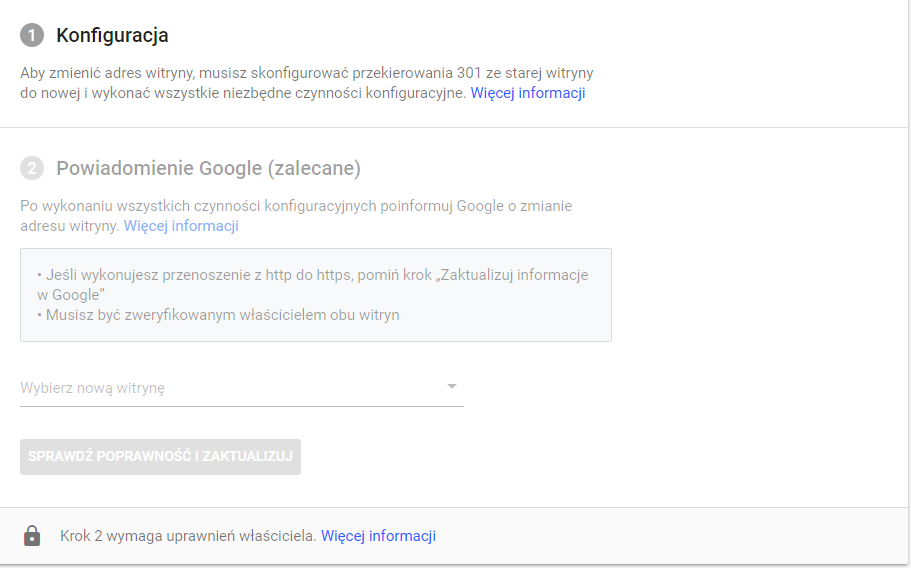

Planując zmianę domeny, warto dodatkowo powiadomić o tym Google, wypełniając stosowny formularz w narzędziu Google Search Console:

Kreator zmiany adresu witryny w narzędziu Google Search Console

Problemy z serwerem

Problemy z serwerem mogą skutkować obniżeniem rankingu strony, które spowoduje spadek ruchu. Mogą też spowodować bezpośredni spadek ruchu z uwagi na fizyczny problem z użytkowaniem serwisu.

Symptomami przeciążenia serwera mogą być błędy typu 500 lub zbyt długie ładowanie się strony.

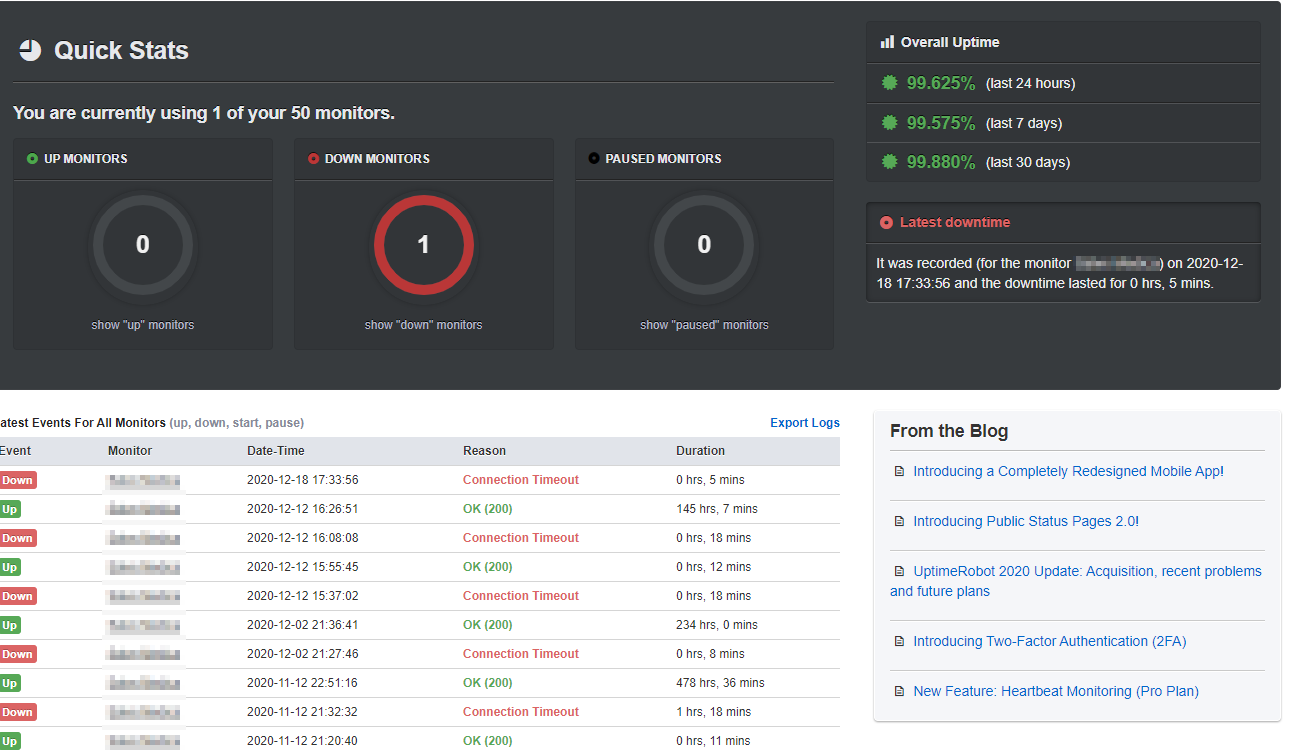

Jeśli awarie będą częste, warto rozważyć zmianę hostingu na inny. Z pomocą analityczną przychodzi nam narzędzie monitorujące dostępność naszej strony www – np. darmowy Uptime Robot.

Przykładowy raport dostępności serwisu w narzędziu Uptime Robot

Za zwiększonym ruchem na stronie powinny iść zwiększone parametry serwera. Większość paneli hostingowych zawiera narzędzie, informujące o poziomie wykorzystania mocy obliczeniowej przydzielonej do naszego serwera.

Szybkość działania naszej strony oraz jej użyteczność zależą także od zastosowanego silnika skryptowego. Popularne systemy CMS mają wiele zalet, np. łatwość wdrożenia. Autorski system CMS daje jednak więcej możliwości. Można dostosować do potrzeb Klienta, wykazuje też większą odporność na potencjalne niechciane ingerencje osób trzecich. Lepsza elastyczność i optymalizacja pod kątem prędkości to kolejne atuty autorskich CMS-ów. Takim właśnie funkcjonalnym i wydajnym narzędziem jest nasz autorski system zarządzania treścią ATOM CMS.

Czasem trzeba zmierzyć się także z sytuacjami kompletnie nieszablonowymi. Przykładem może być tymczasowy spadek widoczności strony naszego klienta – firmy z branży motoryzacyjnej. Następowało stopniowe znikanie domeny z indeksu wyszukiwarki. Absolutnie wszystkie racjonalne powody zaistniałej sytuacji zostały zweryfikowane i wykluczone. W celach testowych umieściliśmy więc serwis na innym serwerze i pod innym adresem. Wówczas strona zaczęła indeksować się normalnie. Zarekomendowaliśmy zmianę serwera, co ostatecznie przyniosło pozytywny efekt – serwis ponownie indeksował się w sposób poprawny i odzyskał swoją widoczność.

Wspomnieć należy, że stary serwer (należący do znanej firmy hostingowej) teoretycznie nie posiadał żadnych cech lub wad, mogących sugerować wystąpienie wspomnianych problemów z indeksacją. Opisany sposób radzenia sobie w podobnej może więc być ostatecznością po wykluczeniu wszelkich innych, potencjalnych problemów. W tym konkretnym przypadku możemy się jedynie domyślać powodów takiego stanu rzeczy. Google mogło na przykład negatywnie oflagować adres IP poprzedniego serwera (nie przeprowadziliśmy w tym kierunku dodatkowych testów). Możliwe, że pod tym samym IP znajdowały się wcześniej strony posiadające treści niezgodne z prawem lub kontrowersyjne.

Niska jakość contentu, thin content lub duplicate content

Istnieje mnóstwo opracowań dotyczących konieczności publikacji na swojej stronie treści wysokiej jakości. Często opracowania te zawierają modne, obcojęzyczne lub zapożyczone z j. angielskiego sformułowania, jak „Google E-A-T”, „treści evergreenowe” i inne.

Krótko podsumowując tę kwestię, treści serwisu powinny posiadać wysokiej jakości użyteczność informacyjną, muszą być wartościowe dla użytkownika. Pogorszenie jakości publikowanego contentu skutkować może obniżeniem potencjału serwisu lub nawet znacznym spadkiem jego widoczności.

Częstą bolączką właścicieli e-sklepów, a także każdego innego rodzaju serwisów www są zduplikowane treści, czyli ta sama zawartość umieszczona w różnych miejscach w sieci. Aby uchronić się przed obniżeniem rankingu Google, należy oczywiście dbać o unikalny content zarówno wewnętrznie, w obrębie strony, jak i zewnętrznie, względem innych treści w sieci. Duplikacja treści występuje m.in. w sytuacjach:

- nieprawidłowo skonfigurowanej funkcji wildcard – gdy wchodząc pod adres dowolnej subdomeny, widzimy duplikację serwisu,

- nieprawidłowej obsługi filtrowania na sklepie lub nieprawidłowej obsługi adresów URL zawierających parametry,

- kradzieży treści,

- braku przekierowań z pozostałych wersji przedrostków witryny na właściwą (np. z wersji zawierającej „www” na wersję bez „www”).

W wykryciu duplikacji wewnętrznej pomoże narzędzie siteliner.com, z duplikacją zewnętrzną radzi sobie copyscape.com. Naprawiając problem duplikacji, najczęściej wykonuje się niektóre z poniższych czynności:

- przeredagowanie zduplikowanych tekstów,

- przekierowania 301,

- zastosowanie znaczników rel=”canonical”,

- usunięcie lub zablokowanie robotom dostępu do zbędnych, zduplikowanych podstron.

Zablokowanie robotom możliwości indeksacji części podstron lub obrazów

Nieprzemyślane zmiany w pliku robots.txt mogą skutkować zablokowaniem dla robotów istotnych elementów lub podstron serwisu, co z kolei skutkować może obniżeniem widoczności. Dotyczy to także innych form blokowania wartościowych treści przed indeksacją przez roboty. Dlatego właśnie systematyczne analizowanie indeksowania naszego serwisu przez roboty wyszukiwarki jest tak istotne.

Zmiana struktury adresów URL lub zmiany w treści

Dokonując zmian istniejących treści, należy robić to ze szczególną ostrożnością, ponieważ możemy narazić się na obniżenie potencjału widoczności. Podczas gdy rozszerzenie treści praktycznie zawsze wpływa na stan witryny pozytywnie, tak modyfikacja wcześniej opublikowanych tekstów powinna być poprzedzona stosowną analizą. Wykreślenie istotnych słów kluczowych, śródnagłówków lub zdjęć może negatywnie przełożyć się na widoczność serwisu w wynikach wyszukiwania określonych zapytań. Przez to ruch organiczny z wyszukiwarki Google również spadnie.

Modyfikacja adresu URL podstrony także powinna być czynnością wcześniej przemyślaną. W niektórych systemach zarządzania treścią, przy zmianie nazwy podstrony, zmieniany jest automatycznie generowany z nazwy adres URL. Skutkuje to bardzo często utratą ruchu.

Gwałtowny spadek prędkości działania witryny lub niedostosowanie do urządzeń mobilnych

Jeśli czas ładowania naszej strony znacznie się wydłuży (np. przez problemy z serwerem) lub przestanie być ona dostosowana do urządzeń mobilnych (choćby z powodu publikacji nieodpowiednio sformatowanej treści), może to skutkować spadkiem ruchu i widoczności w Google.

Od 2021 roku Google traktuje UX jako jeden z czynników rankingowych. Prędkość działania witryny stała się więc bardzo istotnym aspektem optymalizacji serwisu. Wspomóc nas tu mogą na przykład narzędzia (podając wskazówki odnośnie elementów mogących wymagać optymalizacji):

- PageSpeed Insights,

- Pingdom Website Speed Test,

- WebPageTest,

- Konsola w przeglądarce Chrome.

W dobie mobile-first index dostosowanie do urządzeń mobilnych jest także niezmiernie istotną kwestią. Zweryfikować to możemy za pomocą narzędzi Mobile-Friendly Test oraz Google Search Console.

Błędy w adresach URL

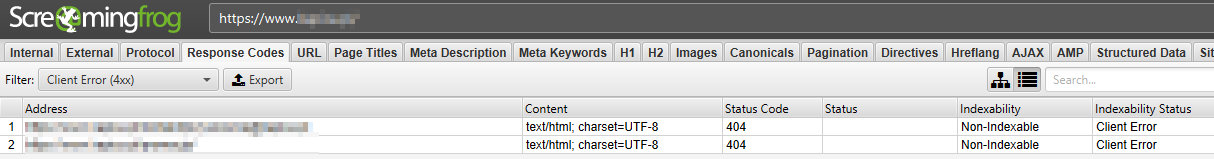

Najczęściej błędy w adresach URL powodują problemy takie jak błędy typu 404 (brak żądanej podstrony) oraz typu 500 (błąd wewnętrzny serwera). Należy je systematycznie analizować i naprawiać.

Raport błędów typu 404 w narzędziu Screaming Frog

Przyrost niskiej jakości linków lub odnośników zawierających anchor text identyczny z promowanym

Nagły przyrost dużej liczby zewnętrznych odnośników kierujących do serwisu, posiadających podlinkowane słowo identyczne z promowaną frazą, może skutkować spadkiem w rankingu wyszukiwarki.

Podobny efekt mogą dać linki niskiej jakości (opublikowane na przykład w wyniku masowego linkowania do treści umieszczonych na naszym serwisie w wyniku włamania).

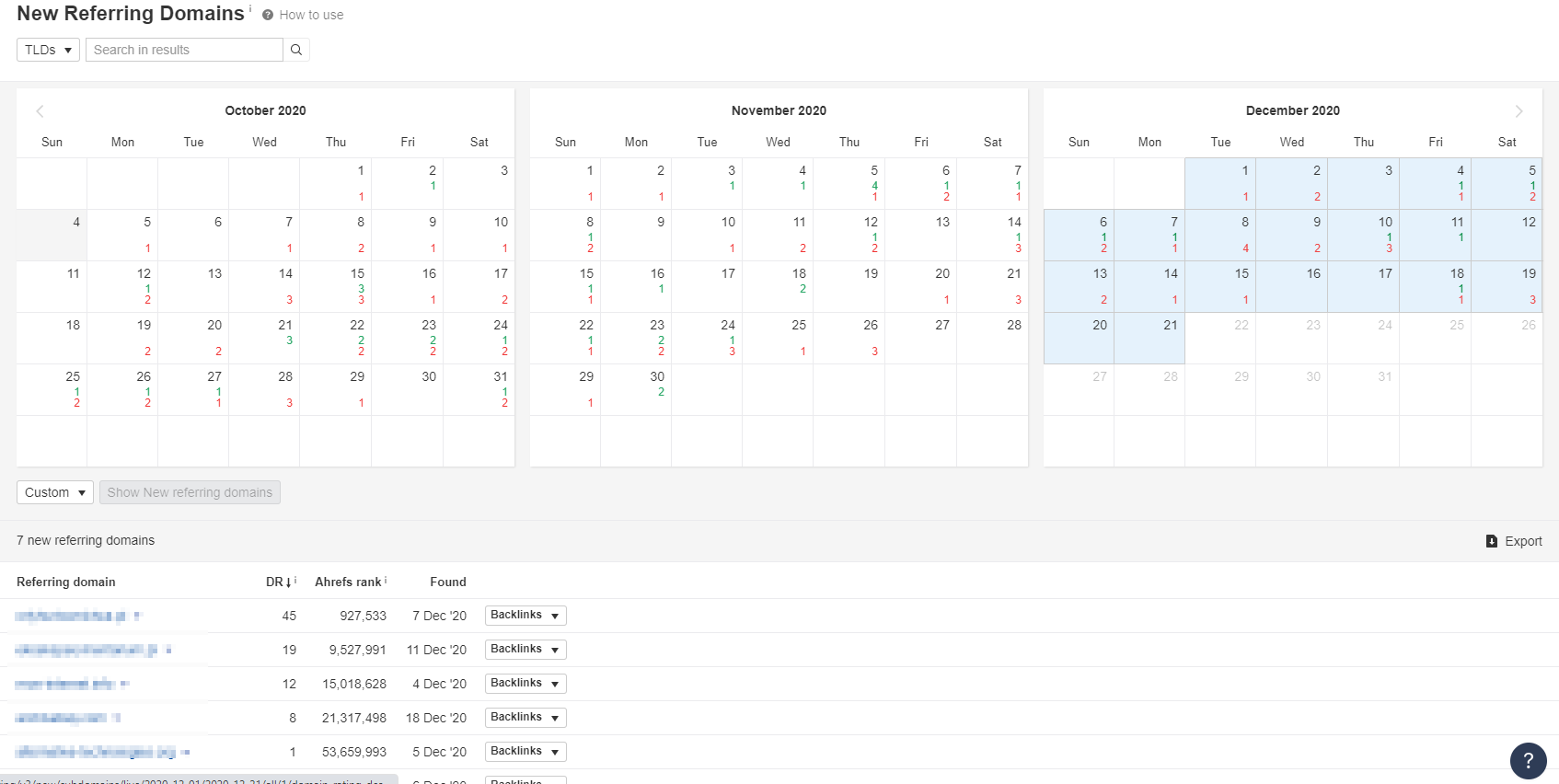

Warto więc na bieżąco analizować profil linków za pomocą narzędzi Ahrefs.com oraz Google Search Console.

Raport nowych domen w profilu linków w narzędziu Ahrefs

Działania konkurencji

W sytuacji dłuższej stagnacji działań zarówno on-site, jak i off-site, należy spodziewać się, że domeny konkurencyjne wyprzedzą nas w wynikach wyszukiwania. Dlatego tak istotne są przede wszystkim:

- systematyczna publikacja nowych treści w obrębie serwisu i rozbudowa istniejących,

- rozwój profilu linków zewnętrznych,

- ciągła optymalizacja techniczna serwisu.

Działania ręczne obsługi Google

Komunikaty związane z ręcznymi działaniami ze strony Google, mogące pojawić się w narzędziu Google Search Console, dotyczyć mogą nienaturalnych linków, spamu w obrębie naszego serwisu, innych działań niezgodnych z wytycznymi Google – np. cloakingu*.

Czynnościami naprawczymi są oczywiście niwelowanie błędów i nieprawidłowych elementów a w dalszej kolejności – wypełnienie formularza wniosku o ponowne rozpatrzenie przez Google problematycznych kwestii.

Zmiany sposobu wyświetlania wyników wyszukiwania przez Google

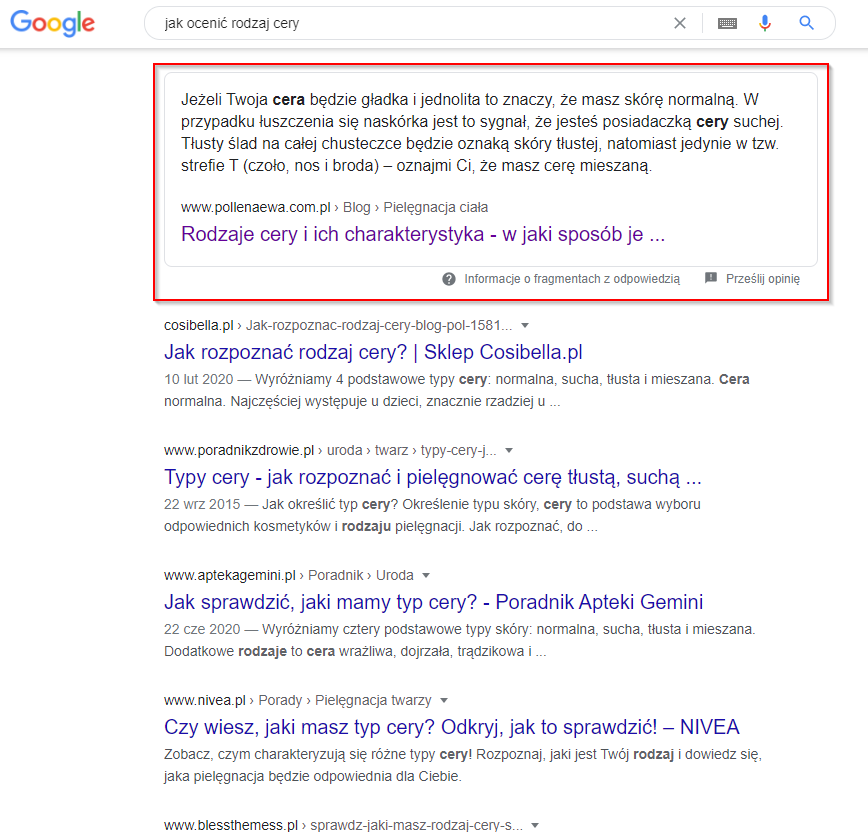

Załóżmy, że nasza strona jest na 2-4 miejscu w wynikach wyszukiwania popularnej frazy. Wyobraźmy sobie też, że Google, nagle, na to zapytanie wprowadza tzw. fragmenty z odpowiedzią. Pierwszy wynik zyska wówczas wyższy CTR, a domenom znajdującym na dalszych pozycjach się on zmniejszy.

Wyniki wyszukiwania zawierające tzw. „fragmenty z odpowiedzą”

Innym przykładem jest zwiększenie liczby boksów reklamowych umieszczonych w górnej części strony wyników wyszukiwania – będzie to miało negatywny wpływ na klikalność w wyniki organiczne.

Nie mamy większego wpływu na politykę wyświetlania przez Google wyników wyszukiwania, ale możemy i powinniśmy zadbać o to, aby nasza strona wyświetlała się w nich w najlepszy możliwy sposób (m.in. optymalizując sekcję meta serwisu).

Jak uniknąć spadków w Google?

Nie da się dokładnie przewidzieć, kiedy ewentualnie może pojawić się spadek ruchu lub widoczności w naszym serwisie. Zdecydowanie warto jednak systematycznie monitorować jego kondycję, co w przypadku pojawienia się błędów lub problemów, pozwoli nam zareagować, zanim zagrozi nam spadek ruchu.

Oprócz monitoringu niezbędny jest oczywiście szereg działań promujących, abyśmy nie zostali wyprzedzeni przez konkurencję.

To wszystko skutkować będzie sukcesywnym wzrostem widoczności i ruchu w obrębie naszej witryny. To z kolei przerodzi się na wzrosty konwersji, a to właśnie na nich najbardziej zależy właścicielom stron www i sklepów.

* zwana też maskowaniem. Polega na prezentowaniu robotom wyszukiwarki innej treści niż użytkownikom.